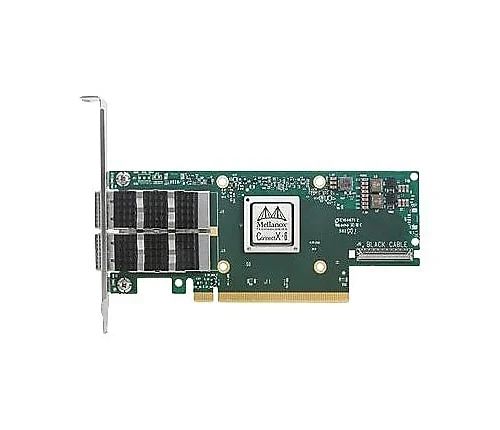

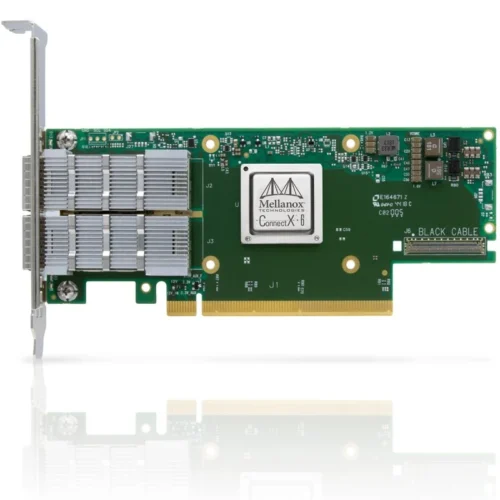

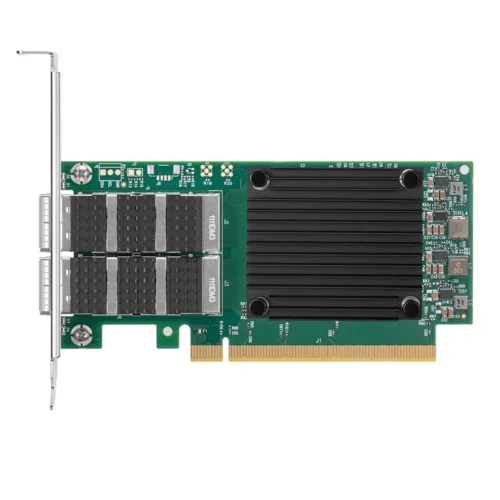

- Débit de pointe, faible utilisation du processeur et taux de messages élevé

- Structure la plus performante et la plus intelligente pour les infrastructures de calcul et de stockage

- Performances de pointe dans les réseaux virtualisés, y compris la virtualisation des fonctions réseau (VPN)

- Technologie Mellanox Host Chaining pour une conception de rack économique

- Interconnexion intelligente pour x86, Pouvoir, Bras, Plateformes de calcul et de stockage basées sur GPU et FPGA

- Pipeline programmable et flexible pour les nouveaux flux réseau

- Performances de pointe dans les réseaux virtualisés, par exemple., VPN

- Activation efficace du chaînage de services

- Efficacité accrue de la consolidation des E/S, réduire les coûts du centre de données & complexité

- Connectivité jusqu'à 200 Gb/s par port

- Bande passante maximale de 200 Gb/s

- Jusqu'à 215 millions de messages/s

- Latence inférieure à 0,6usec

- Chiffrement matériel en mode XTS-AES au niveau bloc

- Compatible FIPS

- Capacités de stockage avancées, notamment le chiffrement au niveau des blocs et le déchargement de la somme de contrôle

- Prend en charge les deux SerDes 50G (PAM4) et 25 SerDes (NRZ)-ports basés

- Le meilleur emballage de sa catégorie avec une précision de l'ordre de la nanoseconde

- Prise en charge PCIe Gen3 et PCIe Gen4

- Conforme RoHS

- Compatible ODCC

spécification

| Physique | Adapter Card Size: 6.6 dans. X 2.71 dans. (167.65mm x 68.90mm) | |||

| Connecteur: Single QSFP56 InfiniBand and Ethernet (copper and optical) | ||||

| Protocol Support | InfiniBand: IBTA v1.4 | |||

| Auto-Negotiation: 1X/2X/4X SDR (2.5Gb/s per lane), DDR (5Gb/s per lane), RDA (10Gb/s per lane), FDR10 (10.3125Gb/s per lane), RAD (14.0625Gb/s per lane), EDR (25Gb/s per lane) port, HDR100 (2 lane x 50Gb/s per lane) port | ||||

| Ethernet: 100GBASE-CR4, 100GBASE-KR4, 100GBASE-SR4, 50GBASE-R2, 50GBASE-R4, 40GBASE-CR4, 40GBASE-KR4, 40GBASE-SR4, 40GBASE-LR4, 40GBASE-ER4, 40GBASE-R2, 25GBASE-R, 20GBASE-KR2, 10GBASE-LR,10GBASE-ER, 10GBASE-CX4, 10GBASE-CR, 10GBASE-KR, SGMII, 1000BASE-CX, 1000BASE-KX, 10GBASE-SR | ||||

| Data Rate | InfiniBand | SDR/DDR/QDR/FDR/EDR/HDR100 | ||

| Ethernet | 1/10/25/40/50/100 Go/s | |||

| Gen3/4: SERDES @ 8.0GT/s/16GT/s, x16 lanes, Socket Direct (2.0 et 1.1 compatible) | ||||

| Adapter Card Power | Voltage: 12V, 3.3VAUX | |||

| Pouvoir | Câble | |||

| Typical Powerb | Passive Cables | 19.4O | ||

| Maximum Power | Please refer to ConnectX-6 VPI Power Specifications (requires NVONline login credentials) | |||

| Voltage: 3.3Aux | ||||

| Courant maximal: 100mA | ||||

| Maximum power available through QSFP56 port: 5O | ||||

| Environnement | Température | Operational | 0°C to 55°C | |

| Non-operational | -40°C à 70°C | |||

| Humidité: 90% relative humidityc | ||||

| Flux d'air (LFM) / | Type de câble | Airflow Direction | ||

| Ambient Temperature | Heatsink to Port | Port to Heatsink | ||

| Passive Cables | 300 / 55°C | 200 / 35°C | ||

| NVIDIA Active 2.75W Cables | 300 / 55°C | 200 / 35°C | ||

| Regulatory | Sécurité: CB / cTUVus / CE | |||

| CEM: CE / FAC / VCCI / CIEM / RCM / KC | ||||

| RoHS: Conforme RoHS | ||||

Informations d'emballage

NVIDIA Mellanox MCX653105A-HDAT-SP is sealed in NVIDIA original box. We will also pack MCX653105A-HDAT-SP with the second box before shipping.

Expédition

Nos produits seront envoyés via FedEx,DHL,TNT,UPS,SME,Et ainsi de suite. Mais l'acheteur est responsable de

Dédouanement et tarif de paiement lorsque le produit est arrivé dans le pays de destination.

méthodes de livraison

2-4 jours ouvrables

2-4 jours ouvrables

2-4 jours ouvrables

Avis

Il n’y a pas encore d’avis.